„The Second Machine Age” Erika Brynjolfssona i Andrew McAfee to optymistyczny głos w debacie o tym, czy wchodzimy w erę wielkiego postępu czy wielkiej stagnacji.

Jedną z naj większych zagadek ekonomicznych ostatnich kilkudziesięciu lat jest pytanie, dlaczego gigantyczny postęp w obszarze technologii komputerowych i informatycznych nie doprowadził do istotnego przyspieszenia produktywności? Już przekładam to na język pierwszej strony popularnej gazety: skoro Internet i komputery dają nam możliwości, o jakich nasi rodzice nawet nie śnili, to dlaczego do cholery nie widać tego w danych o dochodach? Dziś jest to jedna z najbardziej gorących dyskusji w świecie ekonomii (oprócz tematu nierówności).

większych zagadek ekonomicznych ostatnich kilkudziesięciu lat jest pytanie, dlaczego gigantyczny postęp w obszarze technologii komputerowych i informatycznych nie doprowadził do istotnego przyspieszenia produktywności? Już przekładam to na język pierwszej strony popularnej gazety: skoro Internet i komputery dają nam możliwości, o jakich nasi rodzice nawet nie śnili, to dlaczego do cholery nie widać tego w danych o dochodach? Dziś jest to jedna z najbardziej gorących dyskusji w świecie ekonomii (oprócz tematu nierówności).

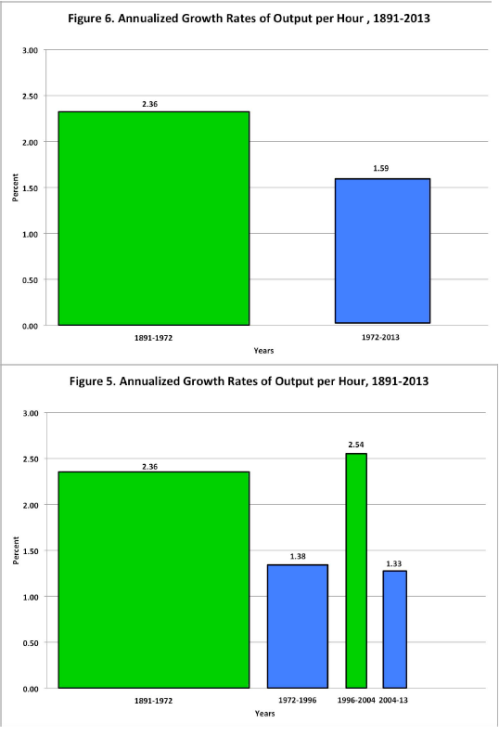

W Stanach Zjednoczonych, które wyznaczają trend rozwojowy i są punktem odniesienia, wzrost PKB na godzinę pracy od lat siedemdziesiątych do dziś wynosił średnio 1,6 proc., podczas gdy przez stulecie do lat 70. było to 2,4 proc. Te 0,8 pkt proc. różnicy to dużo, ponieważ gdyby w ostatnich czterdziestu latach kontynuowany był wcześniejszy trend to średnia produktywność byłaby dziś niemal o 40 proc. wyższa niż jest w rzeczywistości. W 1987 r. znany ekonomista Robert Solow powiedział, że komputery są widoczne wszędzie oprócz danych o PKB. Do dziś właściwie niewiele się zmieniło, a inny znany Robert – Robert Gordon – napisał niedawno artykuł naukowy, w którym przekonuje, że dzisiejsze technologie nie mają już takiej możliwości podnoszenia produktywności jak technologie pojawiające się na przełomie XIX i XX wieku. Szczerze artykuł Gordona polecam, ponieważ jest napisany łatwym językiem i wykorzystuje proste i przemawiające do wyobraźni statystyki. Smutna to mogłaby być konstatacja gdybyśmy się z Gordonem zgodzili, ponieważ niższy wzrost gospodarczy może oznaczać (piszę „może”, ponieważ z tą tezą będę jeszcze dyskutował) większe problemy systemów emerytalnych, większe trudności z obniżaniem długu, większe napięcia społeczne itd.

Na szczęście na kryzys produktywności nie jesteśmy chyba skazani. Eric Brynjolfsson z MIT, który w 1992 r. jako pierwszy sformalizował problem z wpływem technologii IT na produktywność ukuwając pojęcie „paradoksu produktywności”, napisał wspólnie z Andrew McAfee (również MIT) książkę, w której przekonują, że współczesny postęp technologiczny ma i będzie miał ogromny wpływ na produktywność i standard życia. Co więcej, ich zdaniem wchodzimy w drugi wiek maszyn, który pod względem wpływu na produktywność będzie przypominał postęp z pierwszego wieku maszyn, czyli z XIX wieku. Stąd tytuł książki: „The Second Machine Age. Work, Progress and Prosperity in a Time of Brilliant Technologies”. Ich argumentacja bliska jest temu, co każdy uważny obserwator współczesnych trendów musi gdzieś intuicyjnie przeczuwać: postęp technologiczny daje człowiekowi ogromne szanse na podniesienie standardu życia. Jest tylko jeden problem: jak zapewnić udział w tej technologicznej uczcie jak największej liczbie osób? Jak na razie udaje się to słabo.

Jeżeli mam obstawiać – a mimo tendencji do dzielenie włosa na czworo nie lubię mówić, że wszyscy mają rację – to bliżej mi do Brynjolfssona niż Gordona. Patrząc na technologie, nad jakimi pracuje obecnie człowiek, widać gigantyczne wręcz szanse na zrewolucjonizowanie wielu obszarów ludzkiego życia. Oczywiście, kwestia tego, czy będą one podnosiły produktywność w tempie 1 czy 2 proc. jest trudna do rozstrzygnięcia, ale pesymizm Gordona w znacznej mierze opiera się na okresie 2004-2013, kiedy doszło do wyraźnego spowolnienia dynamiki produktywności, która w latach 1995-2004 zaczęła wykazywać wyraźne oznaki reakcji na rewolucję komputerową. Myślę, że to może być zbyt krótki okres, by wyciągać długookresowe wnioski.

Co ważne, choć zarówno Gordon jak i Brynjolfsson/McAfee trafnie diagnozują, że korzyści z rozwoju gospodarczego są coraz bardziej skupione w drobnej grupie najlepiej zarabiających, to Gordon poprzestaje na tej niewesołej konstatacji, jakby była ona czymś „ofiarowanym” ludzkości z góry przez naturę, a Brynjolfsson/McAfee przekonują, że nad dystrybucją korzyści możemy zapanować i oferują recepty. Są to recepty czasem ciekawe, a czasem banalne, ale podejmują próbę zmierzenia się z wyzwaniem nierówności.

Nie byłoby rozwoju gospodarczego, gdyby rewolucji przemysłowej nie towarzyszyła chwalebna rewolucja w Wielkiej Brytanii, rewolucja Francuska, rozwój praw obywatelskich i przywilejów pracowniczych w XIX wieku, które włączyły w życie społeczne setki milionów obywateli, zapewniając nie tylko rynek zbytu ale też gigantyczny potencjał kapitału ludzkiego. Rozważań o długookresowym wzroście gospodarczym nie można oderwać od tematy instytucji politycznych.

***

Dokładnie przed dziesięcioma laty wyszła znana książka „The New Division of Labor”, w której Frank Levy (MIT) i Richard Murnane (Harvard) starali się udowodnić, że komputery i roboty będą przejmowały coraz większą ilość zadań ludzkich, ale nie przejmą zadań, które wymagają złożonej komunikacji (np pozyskiwania informacji, pisania analiz) i czynności nierutynowych (planowania strategii, ale też sprzątania pokoju). Wykonywanie tych zadań zarezerwowane jest dla ludzkiego mózgu. Mogliśmy się zatem obawiać, że komputeryzacja zniszczy niektóre zawody, ale jednocześnie mogliśmy mieć nadzieję, że będą powstawały nowe zajęcia, wymagające większej aktywności umysłowej niż fizycznej czy manualnej.

Książka, choć głośna i wpływowa, dziś powoli traci aktualność. Jak udowadniają Brynjolfsson/McAfee, dziś komputery zaczynają powoli wykonywać zadania dokładnie z tych obszarów, które kiedyś naukowcy uważali za niedostępne dla maszyn – podejmowane są już próby angażowania komputerów w kompleksową komunikację i nierutynowe zajęcia. Samochód Google’a umie już jeździć po autostradzie (co wymaga nierutynowych „umijętności”, ponieważ schematy postępowania kierowców non-stop się zmieniają), a umiejętność jazdy w mieście przestaje być abstrakcją. Pojawiają się pierwsze programy piszące depesze informacyjne – taką usługę w odniesieniu do depeszy o wynikach spółek zamówił np. amerykański magazyn „Forbes”. Naukowcy twierdzą, że w ciągu dziesięciu lat komputery będą umiały rozumieć mowę – na razie podejmowane są średnio udane próby, jak np. aplikacja Siri na iPhone’a, ale trend jest bardzo obiecujący. W ostatnich kilku latach mocno rozwinęła się technologia rozpoznawania i tworzenia map terenów (tzw. SLAM – simultaneous localization and mapping) – na razie mogą ją docenić głównie użytkownicy telewizorów, w których zamiast pilota używamy ruchu ręką, ale możliwości jakie daje ta technologia w dziedzinie transportu i logistyki są niewyobrażalnie szerokie. Wreszcie, coraz większa dostępność danych i możliwości obliczeniowe komputerów czynią realną komputerową diagnostykę medyczną – któż bowiem lepiej rozpozna dolegliwość pacjenta: sam lekarz, czy też komputer mający dostęp do wszystkich badań naukowych i setek tysięcy diagnoz pacjentów?

Książka, choć głośna i wpływowa, dziś powoli traci aktualność. Jak udowadniają Brynjolfsson/McAfee, dziś komputery zaczynają powoli wykonywać zadania dokładnie z tych obszarów, które kiedyś naukowcy uważali za niedostępne dla maszyn – podejmowane są już próby angażowania komputerów w kompleksową komunikację i nierutynowe zajęcia. Samochód Google’a umie już jeździć po autostradzie (co wymaga nierutynowych „umijętności”, ponieważ schematy postępowania kierowców non-stop się zmieniają), a umiejętność jazdy w mieście przestaje być abstrakcją. Pojawiają się pierwsze programy piszące depesze informacyjne – taką usługę w odniesieniu do depeszy o wynikach spółek zamówił np. amerykański magazyn „Forbes”. Naukowcy twierdzą, że w ciągu dziesięciu lat komputery będą umiały rozumieć mowę – na razie podejmowane są średnio udane próby, jak np. aplikacja Siri na iPhone’a, ale trend jest bardzo obiecujący. W ostatnich kilku latach mocno rozwinęła się technologia rozpoznawania i tworzenia map terenów (tzw. SLAM – simultaneous localization and mapping) – na razie mogą ją docenić głównie użytkownicy telewizorów, w których zamiast pilota używamy ruchu ręką, ale możliwości jakie daje ta technologia w dziedzinie transportu i logistyki są niewyobrażalnie szerokie. Wreszcie, coraz większa dostępność danych i możliwości obliczeniowe komputerów czynią realną komputerową diagnostykę medyczną – któż bowiem lepiej rozpozna dolegliwość pacjenta: sam lekarz, czy też komputer mający dostęp do wszystkich badań naukowych i setek tysięcy diagnoz pacjentów?

O ile do niedawna wydawało się, że komputer zastąpi tylko księgowego, to dziś można już przypuszczać, że niedługo skomputeryzowaniu będą mogły ulec niektóre funkcje analityczne a może i menedżerskie; o ile niedawno wydawało się, że komputer określi drogę na mapie, o tyle dziś realne staje się bezzałogowe prowadzenie samochodów (auto Google’a potrafi jeździć na autostradzie, choć jeszcze nie potrafi w miejskim korku); o ile niedawno wydawało się, że komputer może dokonać tylko dobrej diagnostyki obrazowej pacjenta, o tyle dziś wyobrażalne są technologie pełnej diagnostyki stanu chorego. Brynjolffson/McAfee trendy te opisują z nieskrywanym entuzjazmem. Ich zdaniem, moce obliczeniowe komputerów, które od 60 lat rosną dwukrotnie w ciągu każdego roku, oraz gigantyczne zasoby danych sprawią, że coraz bardziej inteligentne maszyny będą wykonywały coraz więcej zadań, ułatwiając ludziom życie. Czyż nie lepiej zdać się na „lekarza” mogącego porównać w ciągu kilku sekund wyniki naszych badań z setkami tysięcy innych przypadków niż lekarza kierującego się li tylko praktyką i intuicją? Czyż nie wspaniale będzie zaoszczędzać 1-2 godziny dziennie dzięki inteligentnym systemom nawigacyjnym rozładowującym korki w miastach lub inteligentnym samochodom? A jak wielkie możemy poczynić osiągnięcia w efektywności edukacji lub np. konsumpcji energii, jeżeli będziemy mieli na bieżące dostęp do danych i systemów optymalizujących nasze zachowania?

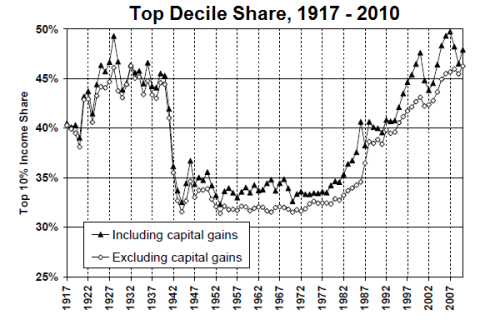

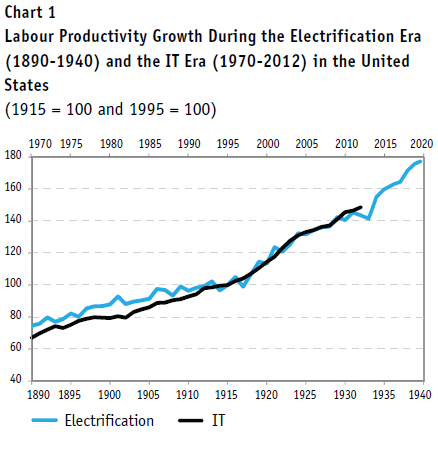

Rozważaniom o postępach technologicznych towarzyszą dwie bardzo istotne obserwacje natury ekonomicznej. Pierwsza jest taka, że innowacje w poszczególnych dziedzinach wzmacniają się nawzajem i mogą przynieść efekt po stronie produktywności dopiero po pewnym czasie. W momencie pojawienia się energii elektrycznej (lata 80. XIX wieku), przez pierwsze 20-30 lat produktywność wcale nie rosła bardzo szybko, ponieważ firmy nie były jeszcze gotowe na maksymalne wykorzystanie możliwości oferowanych przez tę przełomową innowację. Dopiero lata 20 i 30 XX wieku przyniosły znaczące przyspieszenie efektywności pracy. Doskonale pokazuje to ekonomista Chad Syverson (Uniwersytet Chicago) na wykresie, który zamieszczam poniżej. Technologie ogólnego przeznaczenia, czyli takie, które wpływają na wiele obszarów życia, mogą powodować wzrost produktywności falami.

Rozważaniom o postępach technologicznych towarzyszą dwie bardzo istotne obserwacje natury ekonomicznej. Pierwsza jest taka, że innowacje w poszczególnych dziedzinach wzmacniają się nawzajem i mogą przynieść efekt po stronie produktywności dopiero po pewnym czasie. W momencie pojawienia się energii elektrycznej (lata 80. XIX wieku), przez pierwsze 20-30 lat produktywność wcale nie rosła bardzo szybko, ponieważ firmy nie były jeszcze gotowe na maksymalne wykorzystanie możliwości oferowanych przez tę przełomową innowację. Dopiero lata 20 i 30 XX wieku przyniosły znaczące przyspieszenie efektywności pracy. Doskonale pokazuje to ekonomista Chad Syverson (Uniwersytet Chicago) na wykresie, który zamieszczam poniżej. Technologie ogólnego przeznaczenia, czyli takie, które wpływają na wiele obszarów życia, mogą powodować wzrost produktywności falami.

Druga istotna obserwacja dotyczy mierzenia korzyści z postępu technologicznego. Nie chcę dołączać do chóru tych, którzy krytykują w czambuł wskaźnik PKB jako rzekomo nieademamy innego sposobu, ale musimy znać ograniczenia tego. Pamiętam jak mój ojciec zdziwił się, kiedy mu powiedziałem, że stosunek realnego PKB per capita Polski i USA (po uwzględnieniu siły nabywczej) jest obecnie na takim samym poziomie jak w latach 70., czyli że teraz dzieli nas od Ameryki tyle co wówczas. „Jak to? Przecież wtedy żyło się nieporównywalnie gorzej niż dziś!”. Rację mają więc Brynjolfsson/McAfee, kiedy wskazują, że PKB może nie uchwycić wszystkich korzyści ze zmian technologicznych. Spadek krańcowych kosztów produkcji wielu usług (krańcowych, czyli takich, które odnoszą się do jednego dodatkowego produktu) nawet do zera sprawia, że część z nich w ogóle nie będzie rejestrowana w PKB albo będzie rejestrowana tylko w minimalnym stopniu. Gordon też to dostrzega, ale poprzestaje na stwierdzeniu, że PKB nigdy nie mierzył wszystkich korzyści z rozwoju, więc obecne problemy nie czynią wartości tego wskaźnika mniejszej niż przed laty. Ale może Gordon się myli? Może jednak zwiększenie ilości dóbr wirtualnych, które mają zerowe krańcowe koszty produkcji i nie dokładają się do PKB, ale zwiększają standard życia, jednak czyni PKB coraz mniej użytecznym wskaźnikiem?

Brynjolfsson/McAfee piszą tylko o technologiach ICT, ale przecież ogromny postęp otwierający drzwi do wyraźnego wzrostu produktywności widać również w innym obszarze technologii ogólnego przeznaczenia: w energetyce. W Europie zielona energia kojarzy się głównie z kagańcem nakładanym przez Komisję Europejską na poszczególne kraje w zakresie emisji CO2, z nieefektywnością przymusowych inwestycji w wiatraki i panele słoneczne, z drożyzną i zapóźnieniem w stosunku do USA, które zamiast bawić się w wiatraki zaczęły wydobywać znacznie tańszy gaz łupkowy. Jednak w miarę wzrostu efektywności technologii energetycznych, korzyści dla gospodarki będą się znacząco zwiększały.

Jeżeli zatem człowiek oderwie na chwilę oczy od danych o PKB, to nie może oprzeć się wrażeniu, że ostrzeżenia przed zastojem produktywności mogą być przedwczesne.

***

Rozważania o postępie technologicznym i produktywności trudno oderwać od kontekstu społecznego, czyli pytania, dlaczego właściwie ludzie dokonują innowacji i kto na tym korzysta? Brynjolfsson i McAfee dużą część swojej pracy poświęcają dystrybucji dochodu, problemowi stagnacji płac realnych, zjawisku ekonomii gwiazd („superstar economy”), dostrzegając, że druga era maszyn nie przyniosła na razie wielkich korzyści materialnych przeciętnemu członkowi klasy średniej.

Autorzy odrzucają sugestie takich ekonomistów jak Greg Mankiw, że w obserwowanym od trzech dekad wzroście nierówności nie ma nic złego. Wskazują na kilka zjawisk, które mogą budzić niepokój. Po pierwsze, bardzo szybko rośnie różnica między ludźmi dobrze a średnio wykształconymi, co przy problemach z nadążaniem systemów edukacyjnych za zmianami technologicznymi może prowadzić do koncentracji dochodów i majątku w rękach nielicznych obywateli. Nie ma oczywiście nic zdrożnego w wysokiej premii za wykształcenie, problem może być wtedy, kiedy premia ta przyjmie rozmiary trudno do zaakceptowania dla ludzi jej nie posiadających. Po drugie, rynki usług wirtualnych mają tendencję do koncentracji, czyli rynkowej dominacji jednego lub paru podmiotów wymiatających mniejszych konkurentów. Usługi tradycyjne z natury rzeczy musi świadczyć duża liczba podmiotów, a każdy z nich otrzymuje dochód zgodny ze swoją produktywnością. Natomiast w usługach wirtualnych nawet wysoce produktywne podmioty czy osoby będą wymiatane z rynku przez top-performerów. Ci najbardziej produktywni to gwiazdy, które będą zarabiały niewspółmiernie dużo do swoich umiejętności. Psychoterapeuta A, który jest dwukrotnie lepszy od psychoterapeuty B, będzie prawdopodobnie zarabiał dwu lub może trzykrotnie więcej, ale założyciel serwisu społecznościowego C, który jest dwukrotnie lepszy od serwisu społecznościowego D, zgarnie cały dochód na rynku. Po trzecie wreszcie, konkurencja globalna oraz spadek cen dóbr kapitałowych sprawiają, że rośnie zysk z kapitału kosztem zysku z pracy. Przez wiele dziesięcioleci w Stanach Zjednoczonych panował wręcz dogmat, że dochód narodowy składa się mniej więcej w dwóch trzecich z wynagrodzeń za prace i w jednej trzeciej z zysków kapitałowych. Ten dogmat zaczął się łamać ok dwie dekady temu, kiedy udział zysków z kapitału w PKB zaczął szybko rosnąć, a udział wynagrodzeń spadać – teraz płace stanowią już niecałe 60 proc. PKB (w Polsce udział ten również szybko spada, co można wyjaśnić m.in. dużym udziałem kapitału zagranicznego w naszych zasobach kapitałowych). Nie wiadomo jeszcze, dokąd ten trend nas zaprowadzi, ale jest ryzyko, że – podobnie jak rosnąca premia za edukację – będzie on przesuwał dochód i majątek w ręce nielicznych obywateli.

Myślę, że ogromne problemy z popytem wywołane kryzysem finansowym z 2008 r. nieco utrudniają rozróżnienie, które z niepożądanych zjawisk na rynku pracy są zmianami strukturalnymi, a które wynikają tylko z wyjątkowo silnego – ale jednak przejściowego – cyklicznego wahnięcia w dół gospodarki. Ale liczba analiz wskazujących, że narastanie nierówności to proces długotrwały i jednocześnie groźny dla społeczeństwa, jest przygniatająca. Pojawiają się one zarówno po stronie liberalnej (np. Raghuram Rajan w książce „Fault Lines”) jak i socjalnej (Krugman, Stiglitz, Piketty itd.). Głosy takie jak Mankiwa, że wszystko jest okej, znajdują coraz mniejszy posłuch, choć oczywiście w starciach ideowych są one silnym wsparciem konserwatywnej flanki.

U Brynjolfssona/McAfee brakuje mi natomiast nieco głębszego spojrzenia na to, dlaczego nierównomierny podział korzyści z postępu technologicznego może być problemem. Traktują oni postęp jako zjawisko czysto technologiczne, a podział dochodu jako problem towarzyszący, tymczasem zmiany technologiczne i zmiany w instytucjach politycznych zawsze szły ze sobą ściśle w parze – jedne zależą od drugich.

To jak ludzie w historii zwiększali swoje możliwości produkcyjne zawsze szło w parze z tym, jak zmieniały się instytucje przyznające ludziom prawa, przywileje i obowiązki, dlatego o rozwoju gospodarczym i technologicznym praktycznie nie można rozmawiać bez zmian politycznych. Rewolucja przemysłowa zaczęła się w 1775 r., kiedy James Watt zakończył pracę nad maszyną parową. Ale nie byłoby tego osiągnięcia, gdyby nie chwalebna rewolucja w Wielkiej Brytanii pod koniec XVII wieku, która rozszerzyła prawa ekonomiczne i polityczne obywateli (przynajmniej niektórych), gdyby nie oświecenie w Europie i towarzyszące mu idee wolności, gdyby nie wcześniejszy renesans i powolna erozja społeczeństwa hierarchicznego. Właściwie każdy historyk zajmujący się rozwojem gospodarczym w Europie dostrzega, że tło społeczne i polityczne miało kluczowe znaczenie dla uruchomienia mechanizmów rozwojowych. Jeden trend historyczny wydaje się wśród tych różnych zmian dominować: erozja dominacji elit i rozszerzenie praw i znaczenia klasy średniej. Daron Acemoglu i James Robinson udowadniali w swojej książce „The Wealth of Nations”, że rozwój pojawia się tam, gdzie ludzie przestają być ciśnięci finansowo i politycznie przez elity. Z ich tezą można oczywiście dyskutować i część historyków to robi, ale trudno zaprzeczyć, że w Europie erozja znaczenia elit na korzyść znaczenia klasy średniej przynajmniej towarzyszyła procesom rozwojowym.

Jeżeli współczesne trendy gospodarcze doprowadzą do dominacji finansowej wąskiej elity i erozji klasy średniej, to może być to pierwszy krok, by zmarnować osiągnięcia zachodnich społeczeństw ostatnich dwustu lat, jakimi były wysoki poziom dochodu, wysoki standard życia, wysoki poziom bezpieczeństwa itd. Nie mam, bynajmniej, zamiaru rozwijać narracji zagrożenia i konstruować wokół tego politycznych haseł, ale wydaje mi się, że trudno w tym momencie stawiać tezę, na wzór Mankiwa, że zupełnie nic groźnego się nie dzieje. O tych wątkach napiszę zresztą szerzej recenzując książkę Thomasa Piketty’ego „Capital in the Twenty-First Century”.

Do Brynjolfssona/McAfee można mieć też zastrzeżenie, że zbyt słabo rozwijają koncepcje, jak sprawić, by wzrost produktywności umocnił nie tylko elity, ale również klasę średnią. Prosty zestaw standardowych koncepcji, jak rozwój edukacji nastawionej na rozwiązywanie kompleksowych problemów, bardziej efektywny system podatkowy, czy zmiany w prawie patentowym to trochę za mało – to wszystko wiemy bowiem z lektury codziennych mediów. Wiemy też, że wprowadzania tych zmian z jakichś powodów nie postępuje. Widzę dwa potencjalne powody, dlaczego zmiany powszechnie postulowane przez ekspertów nie są wprowadzane w życie. Po pierwsze, może być to zwykły konflikt interesów, a z angażowaniem się w takie konflikty eksperci zwykle mają problem. Jeżeli dystrybucja korzyści ze wzrostu gospodarczego zaczyna stanowić kłopot, trudno uciec od rozważań politycznych – komu zabrać, a komu dać. Uciekanie od takich pytań, uciekanie od problemów idei i wartości, czyni niestety wiedzę ekspercką mniej użyteczną. Po drugie, część proponowanych polityk, które wydają się cieszyć dużym poparciem wśród ekspertów różnej maści, wcale nie udowodniła jeszcze w praktyce swojej skuteczności. Najlepszym przykładem są szkoły społeczne („chartered schools”), które cieszą się znacznie większą autonomią niż szkoły publiczne i dzięki temu mogą rzekomo lepiej przystosowywać programy kształcenia do szybko zmieniających się potrzeb. Chwalenie szkół społecznych jako remedium na sztywność edukacji jest współcześnie bardzo modne. Niestety nie ma jednoznacznych dowodów na to, że szkoły takie rzeczywiście lepiej przygotowują uczniów do wyzwań współczesności i, co istotne, że pomagają włączyć słabsze dzieci w postęp wiedzy (ten temat jeszcze rozwinę).

Książka „The Second Machine Age” to bardzo ciekawy głos w dyskusji o roli technologii, rozwoju gospodarczym i dystrybucji dochodu. Wnioski z niej płynące są dość optymistyczne – ludzkość (czyli najpierw Stany Zjednoczone, a później innych) czeka wielki postęp jakości życia, a nad odpowiednią dystrybucją tego postępu wśród szerokich mas możemy zapanować, jeżeli tylko będziemy chcieli. Jeżeli będziemy chcieli…

IM